Amikor statikus számítógép képernyők, és okostelefonok beszippantják figyelmünket, kiszakítva minket a körülöttünk lévő világból, sok új, érdekes kütyü és elképzelés épphogy megmutatja a visszautat a szabadba.

A mindenre jó, ám teljes fókuszt igénylő eszközök helyett az új gagdetek behelyeznek minket a körülvevő környezetbe, testünkön helyezkednek el, fejünktől a csuklónkon át, füleinkig, ujjbegyeinkig, sőt, akár talpunkon is. E helyeken aztán készenlétben várnak, hogy segítsenek, éppen amikor szükségünk lenne rájuk. Teszik ezt anélkül, hogy elvonnák a figyelmünket arról amit épp csinálunk, ám nehéz őket említeni tudományos fantasztikumra való utalás nélkül.

Ez nem új, azonban napról-napra érdekesebb és egyre inkább látványos jelenség. Ha az ember néhány elszállt ötletet összekapcsol, el is jutott a megszokott felhasználói felületek eltűnéséig.

Horváth András fordítása következik.

A két héttel ez előtti kaliforniai Long Beachen megtartott TED konferencián nem egy beszéd és bemutató világított rá, hogyan tűnik el lassanként az interfész mint olyan, ezáltal mind az input mind az output felhasználóbarátabbá és elérhetőbbbé válik.

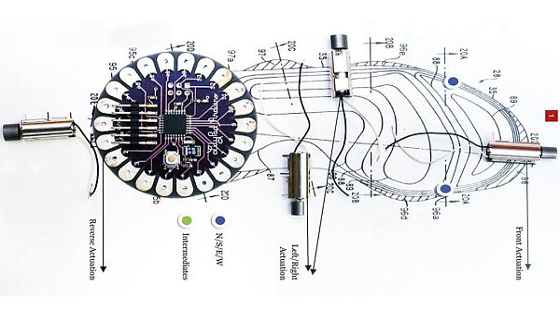

Anthony Vipin Das indiai szemsebész például kifejlesztett egy vak emberek közlekedését segítő rezgő talpbetétet, amely gyengéden vibrálva mutatja a helyes irányt viselője számára.

Vipin Das cége, a Ducere Technologies Hyderabadban található. Termékük, körülbelül 40 dolláros áron lesz elérhető Indiában 6 hónapon belül Le Chal (hindu nyelven: “vigyél oda”) néven.

Példának okáért 20 méterre egy bal kanyartól a Le Chal viselője rövid rezgést érez majd a bal cipőjében. Aztán 10 méterrel később egy hosszabbat. A kanyarnál pedig a betét folyamatosan vibrál majd, egészen addig, amíg tulajdonosa sikeresen be nem fordul balra.

Mindezt fehér bot, kísérő társ vagy bármi egyéb, külső útmutatás nélkül, pusztán úgy, hogy a helyes útvonal “érzete” haptikus jelekkel jut el a felhasználó talpán keresztül.

Az elkövetkező hónapokban Le Chal várhatóan kibővül akadályfelismeréssel és beltéri navigációval is – nyilatkozta Das. Cége egy Morse kód szerű vibrációs nyelven dolgozik, a komplexebb útmutatások és figyelmeztetések beépítése érdekében.

Anthony Vipin Das szerint nem csak a vakok számára jelentenek előrelépést ezek az apró útmutató jelek. “A látó embereknek is előnyökkel kecsegtet a technológia” – emelte ki.

Mindeközben a Google társalapító/helyi őrült tudós Sergey Brin TED beszéde a Google Glass-ról szólt, ennek keretében keresetlen szavaival „férfiatlan”-nak nevezve az okostelefonokat, mivel „a felhasználó csak ácsorog és egy jellegtelen üvegképernyőt simogat össze-vissza”.

A Glass projekt célja hogy az embereket újra teljessé teszi, azáltal (gondolja a cikk írója), hogy fotók és videók készítését kéz nélkül, az adott pillanatnak szentelve figyelmüket, sőt kiegészítésül a telefon értesítéseit is megjeleníti a display. Bizonyos aspektusokban párhuzam vonható az új Pebble karórával, azonban a csukló helyett a szemöldökünk fölött helyezkedik el.

E “szemüveg” viselését nehezen lehet nem furának találni – “az arc Segwaye” hasonlat jól megragadja a lényeget. A felmerülő aggodalmak, miszerint ez az eszköz eltereli a figyelmünket, valamint a privát szférával kapcsolatos aggodalmak több, mint helytállóak.

Mégis, az elképzelések birizgálják az ember fantáziáját. Egy másik beszédben Brinnel a Google X-nél együtt dolgozó Mary Lou Jepsen saját kutatásairól értekezett magas felbontású agy-scannelő rendszerekről, melyek segítségével az emberek dekódolhatnák az agyhullámokat, ezáltal előben láthatóvá válna, mi játszódik le a fejükben.

Jepsen szerint a közeljövőben lehetséges lesz egy élő agyi simulcast kivitelezése. Képzeld el, milyen lenne emlékezni az álmaidra amikor reggel felébredsz, vagy amikor megfejthetővé válik, mi zajlik egy sérült vagy beteg agyban. Tanulmányokban már bizonyították, hogy az agyi scannerek képeket is találhatnak – még ha eléggé homályosakat is –, melyek egyeznek az általunk megnézett vagy elképzelt álló és mozgóképekkel.

„Lehetőségünk lesz ötleteinket egyből a digitális médián keresztül megosztani” – jegyezte meg Jepsen.

Őrülten hangzik mi? Pedig nagyon sok iránya van az interfész mint olyan megszüntetésének. A tengerbiológus Denise Herzing prezentációjában az ember-delfin kommunikációt új szintre emelő viselhető számítógépet mutatott be, amely megfejti és lefordítja a viselőnek a delfinek hangjeleit (azokat is, melyeket az emberek nem hallanak). A Cetacean Hearing és Telemetry (CHAT) névre hallgató rendszer segítségével a búvárok delfin hangjeleket generálhatnak, általuk pedig válaszolhatnak is a delfineknek úszás közben!

A viselhető okoskütyük azonban annyira nem is furcsák. Az emberek testén és azon belül elhelyezkedő szenzorok nem egy geek életének részét képezik. A konferencia idején nem egy résztvevő szolgáltatott adatot aktivitásáról az ingyenes Jawbone Up karkötövel (ám ez semmi: a legnagyobb trend a TED-en: ahogy teltek a napok az egyhetes konferencia során, az Up-ot viselők egyre kevesebbet aludtak).

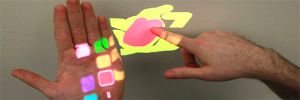

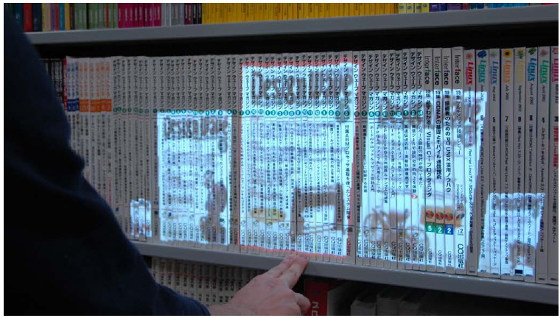

Megállapíthatjuk, hogy a trend, mely szerint a hagyományos értelemben vett interfész eltűnőben van, nem csak konferenciák témáját képező elvont dolog. A Leap Motion nevű startup most jelentette be Windows kompatibilis mozgásérzékelőjének májusi boltokba kerülését. Céljuk, hogy extra érzékeny rendszerükkel kivegyenek egy figyelemelterelő tényezőt a számításokból, lehetővé téve a felhasználók számára virtuális tárgyakat manipulálását, pusztán a képernyő előtt végzett kézmozdulatokkal. Hasonló fejlesztések már nem egy módon a nagyközönséghez is eljutottak: mozgásérzékelős konzolokkal, mint a Wii és az Xbox Kinect – illetve a mindenütt jelenlévő érintőképernyős eszközökben mint az iPad. A felhasználók pedig meg is feledkeznek arról, hogy egy áthatolhatatlan rendszerbe küldenek jeleket, miközben úgy érzik, közvetlenül hatnak rá.

Még 2010-ben a Microsoftos Craig Mundie ezen ötleteket a NUI-nak (natural user interface – természetes felhasználói felület) nevezte el, a jól ismert GUI (graphical user interface – grafikus felhasználói felület) mintájára. Az NUI-k „gesztusokat ölelnek fel, érző computingot jelentenek, kifejező válaszokat adnak, kontextuális és környezeti tudatosságot, 3d-t vagy akár valósnak ható élményeket nyújtanak”.

„Nem feltétlenül kell egy számítógép terminál elé ülni” – mondta Mundie. „A számítástechnika körülötted lesz, és gyakorlatilag egy mindent átható intelligenciával fogsz kommunikálni. Mundie valószínűleg utalt valamire, amire nemsokára készülhetünk is nagy valószínűséggel.